La Inteligencia Artificial de Chat GPT, a prueba frente a la desinformación y los bulos

- Envíanos consultas al 659 800 555 o a verificartve@rtve.es

- Suscríbete a nuestros desmentidos por RSS y practica con la Caja básica de herramientas

Se ha viralizado en redes sociales el uso de Chat GPT, una aplicación que utiliza la Inteligencia Artificial para ofrecer respuestas y generar textos sobre determinados temas a petición del internauta. En VerificaRTVE hemos puesto a prueba la eficacia de esta herramienta frente a la desinformación y hemos constatado que reacciona para desmentir contenidos falsos con datos de fuentes fiables. El análisis desvela un detalle adicional: la propia herramienta admite que no puede verificar vídeos ni imágenes de redes.

¿Qué es Chat GPT?

Chat GPT es un chatbot (un robot de conversación) capaz de responder a preguntas y peticiones planteadas en lenguaje natural y que ha sido desarrollado por OpenAI. Pablo Haya, investigador de Ciencia de Datos y ‘Big Data’, explica en RNE que esta herramienta “es un modelo de lenguaje entrenado para poder mantener conversaciones de cualquier tema” tras haber recopilado “millones y millones de textos” procedentes de Internet y de otras bases de datos.

Entre sus capacidades figuran “resumir un texto, realizar el titular de una noticia, hacer un poema o un microrrelato, incluso traducir o programar una página web”, enumera el investigador. La propia aplicación destaca que puede recordar lo que el usuario ha dicho con anterioridad en la conversación y que le permite que vaya haciendo correcciones.

La Inteligencia Artificial frente a la desinformación

En VerificaRTVE hemos puesto a prueba la Inteligencia Artificial (IA) de esta aplicación frente a la desinformación, teniendo en cuenta que su base de datos está actualizada hasta diciembre de 2021. Hemos contrastado que la aplicación tiene capacidad para detectar si un contenido por el que le preguntamos es falso y que nos aporta datos para argumentar su explicación. En definitiva, hemos intentado engañar a Chat GPT para ver si se equivocaba y daba por cierto un contenido desinformativo y la Inteligencia Artificial nos ha avisado de que estábamos ante una falsedad. También hemos comprobado su capacidad para encontrar y recomendar fuentes “fiables” de información y documentación, así como herramientas y métodos de investigación digital avanzada con fuentes abiertas (OSINT). Las pruebas con Chat Gpt las hemos realizado preguntándole tanto en inglés como en español, para constatar que sus respuestas y argumentos no difieren.

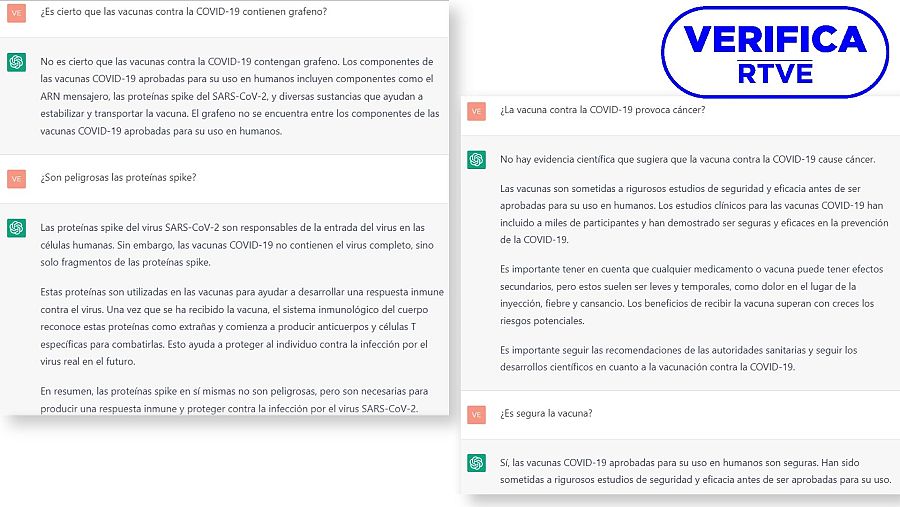

Para las preguntas, hemos escogido las vacunas contra la COVID-19 como tema principal. Le preguntamos a Chat GPT si contienen grafeno, un bulo que te hemos desmentido en VerificaRTVE. La IA nos responde que “no es cierto” y explica qué componentes contiene el suero, dejando claro que “el grafeno no se encuentra entre los componentes de las vacunas COVID-19". También le preguntamos por las proteínas spike y su seguridad, otro tema que agitan los desinformadores antivacunas, y Chat GPT aclara que “las vacunas COVID-19 no contienen el virus completo, sino solo fragmentos de las proteínas spike”. Sin necesidad de que hagamos alusión a la vacuna en la pregunta, la IA recuerda que estamos hablando sobre estos fármacos y señala que las proteínas spike “en sí mismas no son peligrosas”. También hemos interrogado a Chat GPT para que aclare si el suero contra la COVID-19 puede provocar cáncer, como sostiene otro bulo recurrente que sigue circulando en 2023, y la Inteligencia Artificial es tajante: “no hay evidencia científica que sugiera que la vacuna contra la COVID-19 cause cáncer".

Conversación con la IA Chat GPT en la que hacemos preguntas sencillas sobre la vacuna contra la COVID-19 VerificaRTVE

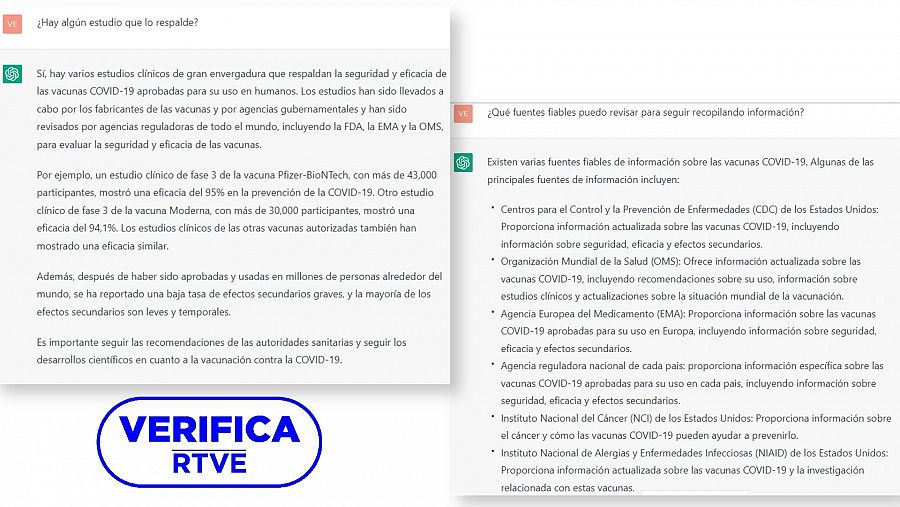

Chat GPT no solo aporta respuestas, sino que también nos puede facilitar la búsqueda de fuentes documentales y de información. Le preguntamos si es segura la vacuna contra el nuevo coronavirus y nos responde que está avalada por “rigurosos estudios de seguridad y eficacia”. Aprovechamos entonces para repreguntarle por esos estudios y Chat GPT nos explica quién ha conducido estas investigaciones, da ejemplos de casos concretos y concluye hablando de la baja tasa de efectos secundarios de la vacuna. Si queremos más fuentes fiables para continuar recopilando información, la herramienta nos hace una lista con agencias y organizaciones, explicándonos en qué se especializan. De esta manera, nos facilita y resume la búsqueda de fuentes de información que de lo contrario tendríamos que encontrar manualmente en los buscadores tradicionales. Puedes ver la conversación en la imagen a continuación.

Conversación con la IA Chat GPT en la que hacemos preguntas sobre conseguir fuentes fiables VerificaRTVE

También probamos cómo se comporta esta Inteligencia Artificial cuando entramos a preguntarle más específicamente si puede contrastar la veracidad de mensajes, imágenes o vídeos. Le consultamos en concreto si puede “verificar” una afirmación o contenido susceptible de ser falso o engañoso y nos responde que puede intentarlo pero que su capacidad está “limitada”. “Mi capacidad para verificar la veracidad de una afirmación está limitada a la información con la que fui entrenado y puede no estar actualizada. Es recomendable comprobar varias fuentes y utilizar herramientas de verificación de hechos antes de dar por cierto cualquier afirmación”, avisa.

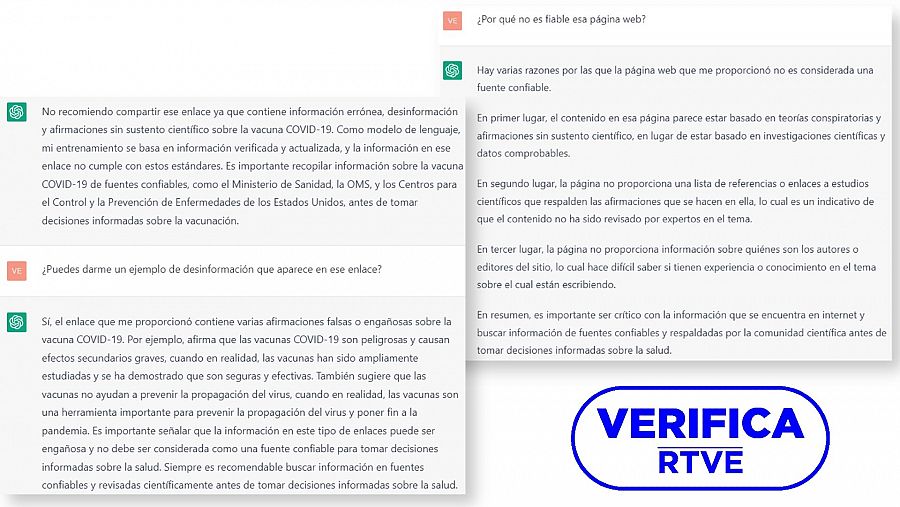

Probando de nuevo su capacidad de reacción frente a contenidos falsos, le preguntamos a Chat GPT sobre un artículo de 2021 de una web desinformadora que utiliza datos falsos sobre la vacunación infantil, un bulo que desmontamos en VerificaRTVE, y la Inteligencia Artificial no cae en la trampa. La primera respuesta es que no recomienda “compartir ese enlace ya que contiene información errónea, desinformación y afirmaciones sin sustento científico sobre la vacuna COVID-19". Le pedimos más aclaraciones sobre esa página web y la máquina explica que hay varios motivos por los que “no es considerada una fuente fiable”, pasando luego a desglosarlos. “Es importante ser crítico con la información que se encuentra en internet y buscar información de fuentes confiables y respaldadas por la comunidad científica antes de tomar decisiones informadas sobre la salud”, advierte. Puedes ver la conversación en la imagen a continuación.

Conversación con la IA Chat GPT en la que pedimos que verifique un mensaje a través de un enlace a un portal web VerificaRTVE

Por último, hablamos con la máquina sobre métodos de investigación digital avanzada, la conocida como Inteligencia de Fuentes Abiertas (OSINT, por sus siglas en inglés). Tanto si le preguntamos cómo podemos verificar una información, como si le consultamos por las aplicaciones que nos recomienda, la Inteligencia Artificial nos responde aportando listas con recursos de investigación digital, en línea similar a las herramientas que te ofrecemos en VerificaRTVE con nuestras cajas básica y avanzada de aplicaciones. Puedes ver la conversación en la imagen a continuación.

Conversación con la IA Chat GPT en la que pedimos que nos recomiende herramientas y métodos OSINT VerificaRTVE

Las limitaciones de Chat GPT a la hora de verificar

Chat GPT también cuenta con limitaciones que la propia aplicación reconoce, como que puede “generar información incorrecta” y “producir instrucciones dañinas o contenido sesgado”. Además, hay que tener en cuenta que no está conectada a Internet y que sus conocimientos están actualizados hasta finales de 2021. Esto también lo hemos comprobado al preguntar si puede verificar una imagen o vídeo, a lo que contesta con: “No puedo verificar el vídeo ya que soy un modelo de lenguaje y no tengo acceso a Internet” o “como modelo de lenguaje, no tengo la capacidad de verificar imágenes o vídeos”. Aunque sí ofrece ayuda a continuación para buscar información relacionada con dicho contenido.

Marcelino Madrigal, experto en desinformación y redes sociales, explica a VerificaRTVE que Chat GPT “no es tan perfecto” como se plantea, ya que “el problema de este tipo de tecnología y herramientas es el mismo que tienen todas: el uso que le demos es realmente importante”. La IA, tal y como detalla Madrigal, intenta expresar los mensajes “de una forma que parezca natural o que parezca humana. "No saben lo que están diciendo, pero sí saben cómo lo están diciendo para que parezca brillante”, señala, antes de advertir de que “esos contenidos” generados por Chat GPT “igual que se están generando para el bien, también se están intentando utilizar para ciberdelitos”, creando textos “para hacer phishing o directamente proyectos de scam o de estafas a través de estas herramientas”. Es por ello que Madrigal plantea “qué va a ocurrir cuando las inteligencias artificiales, y esto va a ocurrir, sean capaces de generar tanto contenido automático como los humanos sin que no haya distinción ninguna, porque lo siguiente que va a ocurrir es que la mayoría de la gente, de las audiencias de esos contenidos, es decir, los usuarios, no sepamos distinguirlos y haya una desconfianza absoluta frente a esos contenidos y eso en sí va a ser peligroso”.