Elecciones EE.UU. 2024 | El uso de la IA como herramienta de desinformación en la campaña

- El uso de la IA en VerificaRTVE para detectar contenidos falsos

- Envíanos consultas al 659 800 555 o a verificartve@rtve.es

El 5 de noviembre se celebran las elecciones presidenciales en Estados Unidos. A lo largo de la campaña hemos detectado narrativas desinformativas que van desde bulos sobre los huracanes Helene y Milton difundidos con fines políticos hasta la desinformación de género sobre Kamala Harris. En todas estas falsedades hemos observado un factor común: el uso de la inteligencia artificial como herramienta generadora de desinformación. En VerificaRTVE analizamos cómo ha influido la IA en la campaña electoral de EE.UU. con la ayuda de un periodista especializado en investigación y verificación.

El uso político de los huracanes con imágenes generadas con IA

En los últimos meses algunas regiones de Estados Unidos se han visto golpeadas por los potentes huracanes Helene y Milton. Estos fenómenos han dejado imágenes que muestran la devastación y los destrozos en varias ciudades estadounidenses. Sin embargo, en redes sociales han circulado contenidos manipulados con inteligencia artificial que se presentan como si fueran reales junto a mensajes favorables al candidato republicano, Donald Trump, y críticos con el Partido Demócrata. El periodista de investigación de Noticias Telemundo y responsable de su sección de verificación, Ronny Rojas, asegura a VerificaRTVE que "la carga desinformativa proviene mucho más del lado de Trump". "No necesariamente estoy diciendo que sea Trump o su grupo el que la esté originando, pueden ser otras personas que simpatizan con la campaña republicana", aclara.

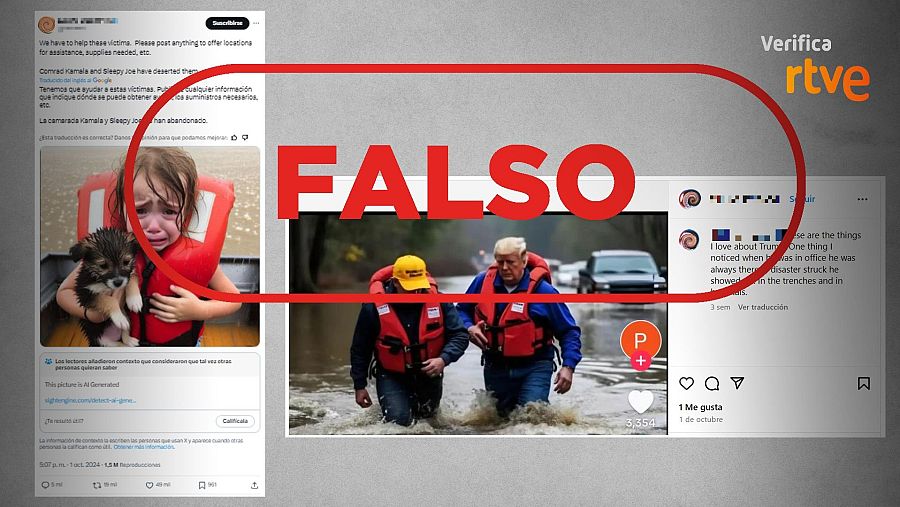

Mensajes que difunden imágenes generadas con IA de los huracanes Milton y Helene como si fueran reales

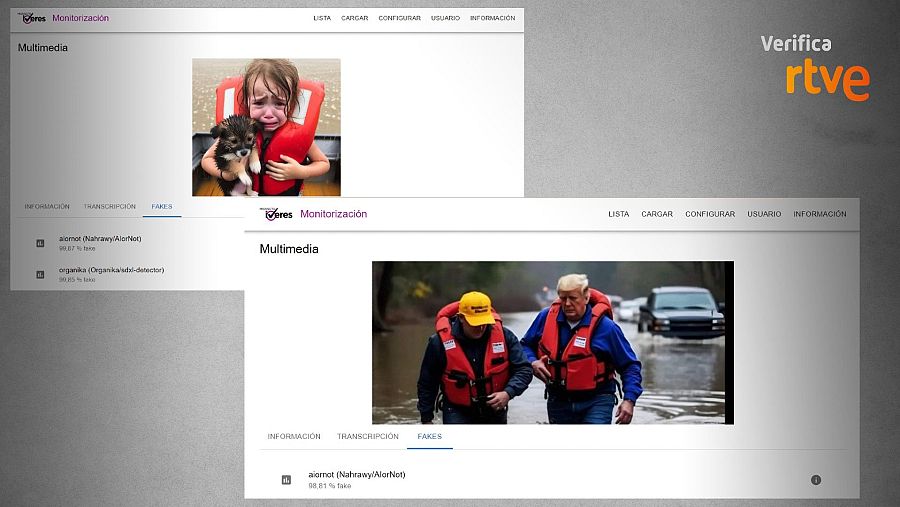

Un ejemplo es la imagen que muestra a Trump con un chaleco salvavidas caminando por una zona inundada y que se difunde junto a mensajes que alaban al expresidente por "salir de los despachos" y ayudar a las víctimas. También es el caso de la fotografía de una niña sosteniendo a su mascota que ha circulado en una publicación compartida más de 19.000 veces que afirma en inglés que Kamala Harris y Joe Biden han abandonado a las víctimas. Estas imágenes no son reales. La herramienta del proyecto IVERES de detección de contenidos generados con inteligencia artificial revela que ambas instantáneas son falsas, como puedes comprobar en la imagen inferior.

Resultados de la herramienta de detección IA del proyecto IVERES

Sobre la imagen de Trump, otro elemento que nos hace sospechar de la autenticidad de la instantánea es que una de las manos del expresidente aparece deformada. Además, la cuenta de YouTube del propio candidato y otros medios de comunicación cubrieron su visita a las zonas afectadas por el huracán y ninguno de ellos publica la fotografía que se ha viralizado en redes (1, 2 y 3).

También han circulado contenidos falsos relacionados con los huracanes con el objetivo de ridiculizar al candidato del Partido Republicano. Es el caso de la fotografía en la que aparece Donald Trump sosteniendo un cheque y que se difunde con el siguiente texto en inglés: "Trump donando 1.300 dólares para ayudas tras el huracán". La imagen se presenta en redes como si correspondiera a una emisión del canal Fox News y los mensajes que la comparten afirman: "¿Un 'multimillonario' está donando $1300? Embarazoso". En otras publicaciones califican a Trump de "tacaño".

Mensajes que difunden una imagen de Trump generada con IA como si fuera real

Esta fotografía no muestra una emisión real de la cadena de televisión Fox News. Se trata de una imagen generada con inteligencia artificial con un "96,26%" de fiabilidad en la predicción que ofrece la herramienta del proyecto IVERES. Hemos comprobado que se publica por primera vez en la plataforma Reddit con un texto en inglés que indica que se trata de una parodia. Además, un portavoz de Fox News ha declarado que esta imagen no fue emitida en su canal, en declaraciones al verificador estadounidense Verify This.

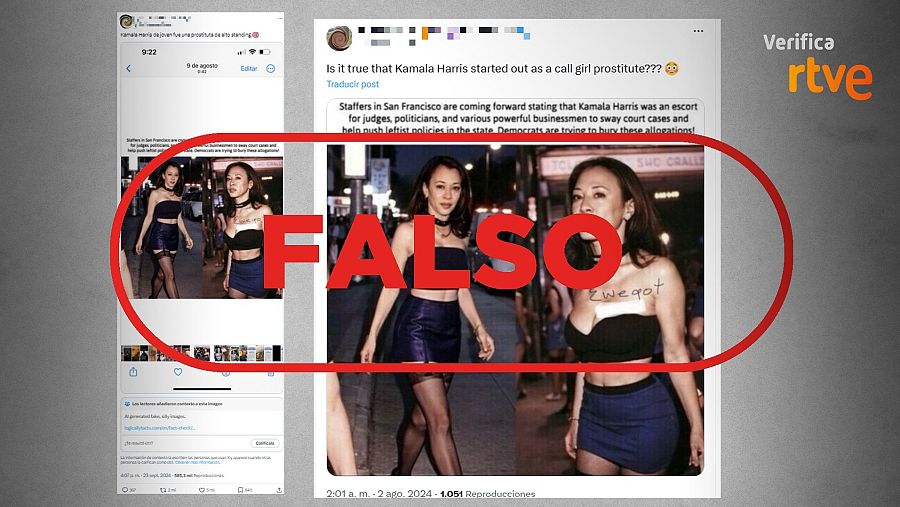

Desinformación de género sobre Kamala Harris

Desde que la actual vicepresidenta de Estados Unidos, Kamala Harris, se convirtiera en la candidata del Partido Demócrata tras la renuncia de Joe Biden, en redes sociales han circulado contenidos falsos en torno a su figura. En VerificaRTVE ya te hemos alertado de las publicaciones que la presentan como si tuviera demencia o que le atribuyen falsas declaraciones y propuestas. También te hemos advertido del uso de fotografías manipuladas que la relacionan con Jeffrey Epstein o el rapero Diddy. Tal y como señala el periodista Ronny Rojas, "hay una carga de desinformación y de mensajes deshumanizantes que rozan la agresión hacia la persona de Kamala Harris". Detalla que son imágenes falsas denigrantes "que muestran a Kamala Harris en situaciones cuestionables".

Mensajes que difunden imágenes manipuladas de Harris como si fueran reales

En VerificaRTVE ya te hemos hablado de la desinformación de género, un fenómeno que consiste en la difusión de falsedades contra mujeres por el hecho de serlo con el objetivo de denigrarlas e invisibilizarlas utilizando métodos como la hipersexualización. Esta práctica la hemos detectado durante la campaña de las elecciones en forma de mensajes de redes que aseguran que Kamala Harris era una prostituta de lujo antes de dedicarse a la política. Las publicaciones se difunden junto a fotografías que muestran a la candidata demócrata vestida con minifalda, pero estas imágenes están manipuladas con inteligencia artificial. La herramienta del proyecto IVERES refleja que se trata de contenidos falsos con un "94 %" de fiabilidad en la predicción. El verificador estadounidense Snopes también califica estas instantáneas como falsas después de que un experto concluyera que la cara de la mujer vestida de negro "no coincide en absoluto" con la de Kamala Harris. Sobre la imagen en la que viste de color rojo, este especialista afirma que "es muy probable que se trate de una simple manipulación con Photoshop".

Los bulos dirigidos a la población migrante

El responsable de T Verifica, Ronny Rojas, ha detectado bulos especialmente dirigidos a la población migrante de Estados Unidos con el objetivo de influir en su voto. Nos habla de las "fotos que han circulado de Donald Trump acompañado de personas negras que de alguna manera lo muestran en una actitud muy amistosa con la comunidad afroamericana con el objetivo de manipular" a este grupo de votantes. Un ejemplo es la imagen de Donald Trump sentado frente a un porche rodeado de seis jóvenes negros que en Instagram se ha difundido junto al siguiente texto sobre impreso en inglés: "Hicieron señas a su caravana y bajó para hacerse una foto rápida, con los estadounidenses". También ha circulado una foto del expresidente abrazando a dos mujeres negras junto a otras personas, todas de piel morena. Una publicación comparte la instantánea en X y afirma en tono sarcástico: "Es necesario contener el racismo de Donald Trump, dice la izquierda".

Mensajes que difunden imágenes de IA como si fueran reales

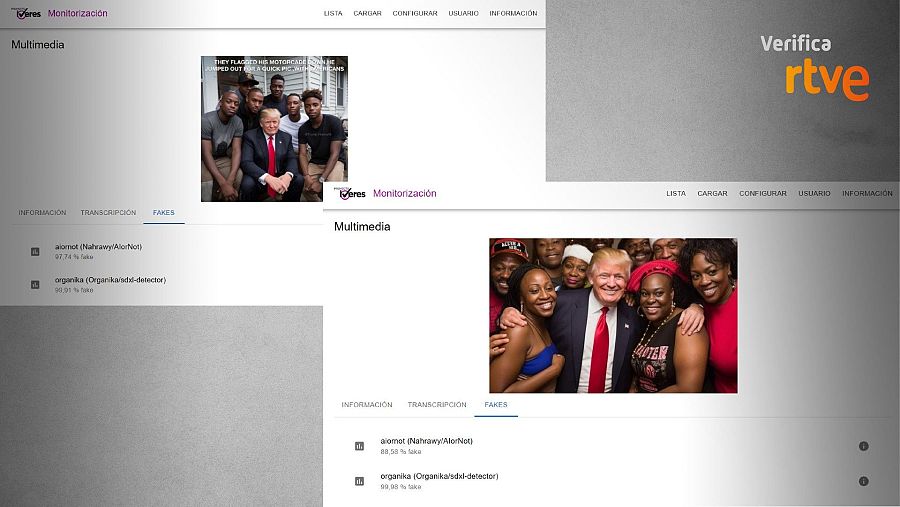

Estas fotografías no son reales, están generadas con inteligencia artificial. Un análisis realizado con la herramienta de detección de contenidos creados con IA del proyecto IVERES revela que ambas instantáneas son falsas, como puedes comprobar en la imagen inferior. Además, medios de comunicación y verificadores han alertado de que se trata de fotos falsas que se difunden para intentar atraer el apoyo de los votantes negros a Trump (1, 2).

Resultados que ofrece la herramienta del proyecto IVERES sobre las dos fotos falsas

Ronny Rojas hace hincapié en los ciudadanos latinos e hispanohablantes subrayando que este colectivo es "mucho más vulnerable a la desinformación en Estados Unidos por diversas razones", una de ellas es "por la forma en cómo nos comunicamos". Nos explica que "muchas de estas narrativas falsas circulan en chats de mensajería privada como WhatsApp", lo que hace que sea "muy difícil rastrearlo para los factcheckers". Rojas añade que "los textos [falsos] están en español" y, en este sentido, critica que "las plataformas no dedican la misma cantidad de dinero para controlar y desmentir la desinformación que circula en español". Un estudio de la ONG Human Rights Watch también concluye que la desinformación sobre las elecciones estadounidenses afecta más a la población migrante. Este trabajo sostiene que "los inmigrantes que dependen de contenido traducido, a menudo se ven sometidos a traducciones erróneas en grupos de WhatsApp y otras plataformas de redes sociales, donde la moderación de contenido en español es limitada". Añaden que "estas amenazas se ven amplificadas por el auge de la inteligencia artificial (IA)", una herramienta que "los actores maliciosos también pueden usar para llegar a las comunidades de color con aún más precisión".

Mensaje que difunde una captura de vídeo de Harris y Walz creado con IA como si fuera real

Ronny Rojas nos pone como ejemplo esta captura que ha circulado por WhatsApp en Estados Unidos y en Venezuela. La imagen muestra a Kamala Harris junto al candidato demócrata a la vicepresidencia de Estados Unidos, Tim Walz, haciéndose un selfi frente un cartel en el que leemos: "Comunistas Revolucionarios de América". Se comparte en Instagram junto al siguiente mensaje: "Voy a dejarle esto por aquí a mis amiguitos demócratas te veré dentro de un tiempecito si esta mujer sale como presidente pidiendo el último por picadillo". Es falso. Harris y Walz no se han fotografiado frente a un cartel procomunista, la imagen está manipulada. La instantánea es una captura de un vídeo manipulado de una visita a una oficina de campaña en Glendale (Arizona) el 9 de agosto. Un periodista de 12News publicó la grabación original en su cuenta de X. En el repositorio de Getty Images puedes ver varias fotos tomadas por el reportero gráfico Andrew Hanrik (1, 2 y 3). Puedes comprobar que la vestimenta de los candidatos demócratas es la misma, pero los carteles que figuran en la escena no son los que aparecen en la imagen de redes.

Teorías conspirativas sobre el intento de asesinato a Trump

La tarde del 13 de julio Donald Trump resultó herido leve en una oreja por una bala mientras intervenía en un acto de campaña en Butler, Pensilvania (EE.UU.). Desde ese momento, las redes sociales se llenaron de bulos de los que ya te advertimos en VerificaRTVE. Entre toda esta desinformación, observamos el uso de la inteligencia artificial para trasladar mensajes falsos sobre este episodio. Es el caso de la fotografía que difunden para afirmar que los agentes del Servicio Secreto estaban sonriendo cuando fueron a socorrer al candidato republicano y que sirvió para alimentar las teorías conspirativas que aseguraban que todo estaba orquestado.

Mensajes que difunden una imagen del ataque a Trump generada con IA como si fuera real

La foto en la que tres agentes del Servicio Secreto de Trump aparecen sonriendo durante el atentado contra el expresidente ha sido alterada digitalmente. La imagen original la encontramos publicada en una fotogalería de la agencia de noticias Associated Press (AP). Tal y como puedes comprobar, ni en esta ni en el resto de instantáneas publicadas en el repositorio los agentes aparecen sonriendo. En este vídeo de la televisión estadounidense CNN que muestra el momento de los disparos y los instantes posteriores también puedes observar que ningún miembro del Servicio Secreto sonríe. Un análisis forense de la imagen realizado por Factchequeado revela signos de manipulación en los rostros de los agentes.

Mensaje que comparte una imagen de IA para difundir el bulo de que una mujer trans intentó asesinar a Trump

Otro ejemplo es esta fotografía de una persona con gafas y pelo largo a la que presentan como si fuese una mujer transgénero, autora del atentado. En VerificaRTVE ya te explicamos que la imagen que compartían en redes sociales está generada con inteligencia artificial. Vincular a las personas transgénero con actos delictivos es una práctica habitual de los desinformadores que buscan extender el discurso de odio contra el colectivo LGTBIQ+. Es una de las narrativas de las que te hablamos en el glosario de bulos que publicamos con motivo del Orgullo 2024.

La IA para engañar sobre el apoyo que reciben los candidatos

La inteligencia artificial también ha irrumpido con fuerza en la guerra entre los candidatos por ver quién recibe más y mejores apoyos. Se trata de una narrativa desinformativa en la que se difunden imágenes alteradas con inteligencia artificial para presentar a personas famosas apoyando a los candidatos o para sembrar dudas sobre el número de asistentes a sus mítines. En redes sociales encontramos varios ejemplos de fotografías falsas de la cantante Taylor Swift mostrándose a favor de Donald Trump o del actor Ryan Reynolds luciendo una camiseta con el nombre de Kamala Harris.

Imágenes de Taylor Swift y Ryan Reynolds generadas con IA

Estas imágenes no son reales. La fotografía de Ryan Reynolds con una camiseta en la que leemos en inglés: "Kamala, elimina las desagradables manchas naranjas" ha sido alterada digitalmente. En el perfil de Instagram del actor puedes comprobar que no lleva tatuajes en su brazo. Cinco días antes de que la imagen falsa se difundiera en redes Ryan Reynolds acudió a un evento en San Diego. En estas instantáneas del fotógrafo de AFP Chris Delmas observamos que los brazos reales del actor no se corresponden con los de la instantánea falsa y que no tenía ningún tatuaje (1 y 2). El verificador Snopes también calificó esta imagen como falsa al observar "inconsistencias en la iluminación, las sombras y la textura del logotipo y el texto de la camiseta que sugieren que el eslogan se ha añadido digitalmente a una imagen existente de Reynolds o que la cabeza del actor se había superpuesto al cuerpo de otro hombre". En cuanto a las instantáneas que muestran a Taylor Swift y sus fans apoyando a Donald Trump, en VerificaRTVE ya te explicamos que estaban generadas con inteligencia artificial.

A la izquierda, imagen real que se difunde como si fuera generada con IA. A la derecha, imagen de IA que presentan como si hubiera difundido el equipo de Harris

Asimismo, te advertimos de cómo se estaban utilizando imágenes generadas con inteligencia artificial para acusar a Kamala Harris de añadir más público a sus mítines. En este caso, observamos una doble tendencia. Por un lado, la difusión de instantáneas reales de un mitin en el aeropuerto metropolitano de Detroit que se presentaban como si hubieran sido generadas con IA. Por otro, imágenes falsas de gradas con público que se adjuntaban a mensajes que aseguraban que las había difundido el equipo de Kamala Harris.