"La tecnología está disponible, pero son necesarios datos y los datos están en RTVE"

- La Cátedra de RTVE con la Universidad de Zaragoza presentan los resultados del Reto Albayzín RTVE 2020

- Es el segundo reto lanzado por la Cátedra a grupos de investigación y empresas en el ámbito de las tecnologías del habla, la visión artificial y el procesamiento del lenguaje natural

- Su objetivo es impulsar el estudio y desarrollo de la Inteligencia Artificial aplicada al sector audiovisual y, de forma más concreta, a los archivos de radio y televisión

El pasado 17 de marzo, como parte de las actividades de la Cátedra de RTVE con la Universidad de Zaragoza, se presentaron los resultados del Reto Albayzín RTVE 2020 en tecnologías de Inteligencia Artificial aplicadas al sector audiovisual. En esta jornada se dieron a conocer los ganadores en cada una de las categorías, y se destacó el valor de la colaboración entre investigación y empresa como el principio esencial para alcanzar soluciones tecnológicas adecuadas a las necesidades de los medios audiovisuales. RTVE demuestra con esta iniciativa su vocación de servicio público impulsando el desarrollo de tecnologías punteras y su compromiso con la investigación haciendo accesibles datos para la comunidad científica.

El Reto a escena

Este acto, celebrado en el Instituto RTVE, contó con la participación de la Secretaria General de RTVE, Verónica Ollé, y del Vicerrector de Política Académica de la Universidad de Zaragoza, José Ángel Castellanos,junto a las intervenciones de Pere Vila, director de Estrategia Tecnológica e Innovación Digital de RTVE y del Director del Fondo Documental RTVE, Alberto de Prada.

En esta jornada estuvieron representados grupos de investigación de primera línea como VivoLab (Universidad de Zaragoza), AtlantTic (Universidad de Vigo) y el Centro Tecnológico Vicomtech. Investigadores de estos grupos, junto al Director de la Cátedra RTVE – Universidad de Zaragoza, Eduardo Lleida, reflexionaron sobre la necesaria colaboración entre industria, ciencia y empresas y pusieron de manifiesto la relevancia de retos como el Albayzín RTVE 2020 para desarrollar tecnologías útiles y adaptadas al sector audiovisual.

El acto fue abierto por la Secretaria General de RTVE Verónica Ollé, y el Vicerrector de Política Académica de la Universidad de Zaragoza, José Ángel Castellanos, quienes destacaron el compromiso de RTVE con la investigación y el valor de la colaboración entre industria y universidad para el impulso de la Inteligencia Artificial. José Ángel Castellanos destacó la necesidad de contar con grandes cantidades de datos que permitan a la ciencia seguir avanzando y, en este sentido, agradeció el gran esfuerzo que RTVE ha realizado para poner a disposición de la comunidad científica estos datos mediante la RTVE Database 2020.

Virginia Bazán (RTVE) y Alfonso Ortega (UNIZAR) RTVE

Antonio Miguel, de la Universidad de Zaragoza, presentó los pilares sobre los que se ha desarrollado la Inteligencia Artificial en la última década con su conferencia “Inteligencia Artificial para organizar sonidos, imágenes y textos… ¿Qué hay detrás de la cortina?”. La Inteligencia Artificial, afirmó en su ponencia, ha irrumpido con fuerza en todos los ámbitos de trabajo y está afectando a la forma en la que los profesionales desempeñan su labor, es por ello que, cuanto más profundo sea el conocimiento de esta tecnología y sus posibilidades entre los profesionales que la usan, mayores serán las oportunidades para desarrollar soluciones útiles y adaptadas.

De forma muy gráfica Antonio Miguel explicó el funcionamiento de las redes neuronales y como el uso de algoritmos permite mejorar los procesos a través del aprendizaje. Así mismo, destacó la importancia de contar con datos masivos para el entrenamiento de los sistemas y señaló que los datos pueden aportar sesgos. ¿Cómo es posible saber que los datos se están presentando en una proporción adecuada para evitar estos sesgos?, se preguntaba Antonio Miguel, quien opina que hasta que esto sea posible tecnólogos y usuarios deben ser conscientes de que existen implicaciones éticas en el uso de las tecnologías. El profesor Miguel presentó también algunas de las aplicaciones más comunes de la IA para el sector media y su evolución en los últimos años, como la clasificación de imágenes, la predicción de textos e imágenes o la generación e incrustación de publicidad en tiempo real. Antonio Miguel finalizó la conferencia destacando la importancia de retos con el RTVE-Albayzín para fomentar la investigación, el aprendizaje y la comunicación de resultados.

Antonio Miguel (UNIZAR) RTVE

Tras este análisis entre bambalinas, llegó la oportunidad de poner estas tecnologías en el escenario de los medios de comunicación. Alfonso Ortega de la Universidad de Zaragoza, José Luis Alba de la Universidad de Vigo y Aitor Álvarez de Vicomtech, reflexionaron sobre las aplicaciones de la Inteligencia Artificial en el sector audiovisual. Alfonso Ortega se centró en las tecnologías que permiten detectar la voz de una persona de forma que, mediante la asignación de etiquetas, sea posible identificar y recuperar todos y cada uno de los fragmentos de correspondientes a una voz en un contenido media. El profesor Ortega se detuvo en los logros pero también en las limitaciones de estas tecnologías, puesto que buscar una voz en un archivo, afirmó, no siempre es un juego de niños. Al contrario, esta puede ser una tarea compleja que hace que los sistemas arrojen tasas de error relativamente altas entre el 10% y el 20% como consecuencia de la variabilidad del entorno acústico (música, aplausos, risas), voz emocional, intervenciones muy cortas, solapamiento entre hablantes, etc. Si bien hay entornos como los informativos, los debates ordenados o las entrevistas en los que es posible obtener tasas de error por debajo del 10%. Para finalizar, Alfonso Ortega señaló que estamos ante tecnologías robustas que requieren, no obstante, ser adaptadas a problemas concretos para mejor su rendimiento.

El profesor Alba centró su presentación en el reconocimiento multimodal, es decir, en el uso simultáneo de voz, reconocimiento facial, reconocimiento de texto en pantalla y reconocimiento del contexto en que se produce la escena y sus múltiples aplicaciones en el sector media. Durante su intervención señaló algunas de las dificultades a las que se enfrentan los sistemas como son los rostros que no aparecen en primer plano, las pantallas partidas, las escenas en el exterior (donde las poses y las expresiones son menos comunes que en un estudio), la presencia de caras en pantalla a las que no corresponden ninguna voz o los parecidos razonables entre dos personas. José Luis Alba destacó la complejidad del Albayzín-RTVE 2020 como consecuencia de la variedad de programas que formaban el reto, algo que por otra parte, señaló, nos ayuda a detectar dónde se concentran los problemas. En este sentido, recalcó la dificultad del reconocimiento facial en entornos abiertos, como paso previo a la identificación de personas, si bien, destacó que, en reconocimiento de identidades, cuando no hay grades variaciones de edad, pueden alcanzarse tasas de acierto superiores a las de un humano. Al igual que el profesor Ortega, José Luis Alba coincidió en señalar que la tecnología ya es útil entornos sencillos como platós, con buena acústica, poco movimiento de cámara o escaso solapamiento de voces.

Aitor Álvarez, del centro tecnológico Vicomtech, dedicó su intervención al procesamiento del habla. Estas tecnologías permiten comprender qué se dice, quién, cuándo y cómo lo dice (reconocimiento de emociones), en qué entorno acústico se hace y en qué idioma. Esta tecnología, que se encuentra integrada ya en aplicaciones de uso diario como los asistentes personales como Siri, Alexa o Cortana, tiene aplicaciones específicas en el sector audiovisual como el seguimiento de medios, la generación de subtítulos para mejorar la accesibilidad y por supuesto, la generación de metadatos para la recuperación de contenidos audiovisuales y su preservación. Las principales dificultades con las que se encuentran estos sistemas, a juicio de Álvarez, están en buena medida relacionadas con la disponibilidad de datos correctamente anotados. El habla espontánea, la dicción, el ritmo con el que se habla, la voz actuada, los acentos y dialectos ponen a prueba el rendimiento de estas tecnologías, sin perder de vista que los sistemas de reconocimiento funcionan mejor cuando se adaptan a dominios concretos. A pesar de que muchos sistemas pueden superar el rendimiento de un humano en determinados contextos, en su aplicación para el sector media la precisión máxima suele estar en torno al 90% de acuerdo con los datos obtenidos en la evaluación de Red Bee Media (2018), aunque hay que tener en cuentaque la evolución y mejora es constante. Como conclusión Aitor Álvarez señaló que, si bien muchos sistemas son capaces de alcanzar tasas de error por debajo del 20%, es necesario comprender en qué entornos requieren los medios de comunicación mejores tasas de error ya que la aplicación de estos sistemas puede realizarse en contextos distintos, como son los casos del subtitulado o el etiquetado de contenidos de archivo.

Tras estas presentaciones se planteó como elegir la tecnología más adecuada en el ámbito de los medios de comunicación y, de forma más concreta, en el contexto de los archivos de radio y televisión. Alfonso Ortega destacó una vez más la necesidad de establecer una colaboración estrecha entre tecnólogos y usuarios de la tecnología, de forma que los primeros puedan comprender los contextos de aplicación de las tecnologías y las necesidades reales de quienes las usan. La clave, afirmó, es generar herramientas que permitan mejorar el trabajo. José Luis Alba, por su parte, destacó la necesidad de crear retos como Albayzín-RTVE 2020 orientados a problemas concretos, así como establecer prioridades que permitan el desarrollo de soluciones adecuadas a determinados dominios, bien publicitados y capaces de atraer a grupos internacionales para fomentar una competencia más sana. En este sentido, Aitor Álvarez destacó la participación de grupos de investigación nacionales e internacionales de gran nivel y señaló que retos, como el que se presentan en esta jornada, ofrecen indicadores útiles para la puesta en producción de estas tecnologías y muestran, a los grupos de investigación, cuáles son las necesidades reales y dónde están los verdaderos retos una vez que la tecnología sale del laboratorio. Todos ellos coincidieron en señalar la importancia de adoptar de forma temprana la tecnología permitiendo que, sean el propio sector media y en concreto los archivos de radio y televisión, los que puedan definir y decidir la evolución de los sistemas. Adopción temprana, por tanto, pero de forma planificada, lo que supone identificar prioridades y, en función de los resultados, incrementar la dificultad de las tareas para mejorar con ello el rendimiento de los sistemas. El debate concluyó con una conclusión clara: la necesidad de profundizar en la colaboración entre industria e investigación.

Los ganadores se dan a conocer

Tras este intercambio de ideas, Carmen Pérez Cernuda, Subdirectora de Innovación y Estrategia Tecnológica de RTVE, y Eduardo Lleida, Catedrático de la Universidad de Zaragoza y director de la Cátedra RTVE-UNIZAR presentaron los resultados del Reto Albayzín-RTVE 2020. Carmen Pérez puso en valor el trabajo realizado por la Cátedra RTVE – Universidad de Zaragoza desde 2017 y destacó que, durante estos años de colaboración intensa, RTVE ha alcanzado un importante conocimiento de la Inteligencia Artificial, un avance que se ha podido concretar en la publicación de distintas licitaciones para la puesta en marcha de soluciones basadas en Inteligencia Artificial. En este sentido, destacó Carmen Pérez, desde la Dirección de Estrategia Tecnológica e Innovación Digital de RTVE y, en colaboración con distintas áreas de la Corporación, se han impulsado servicios que ya están en funcionamiento como el de segmentación de noticias para mejorar la accesibilidad de los contenidos de RNE; la generación automática de noticias de contenido deportivo y carácter local; el de subtitulado automático para los informativos producidos por los centros territoriales en castellano y de los informativos bilingües, ya funcionando en Valencia y Baleares y en breve también lo estará en gallego y euskera; el de otros servicios que se implantarán en próximos meses, como la cobertura de las elecciones locales en poblaciones de menos de 1.000 habitantes; los sistemas de ayuda a la gestión que, basándose en el análisis de los contenidos informativos generados por RTVE sean capaces de detectar información relacionada con un tema, caso de los ODS por poner un ejemplo; o el metadato automático de más de 11.000 horas de contenidos del archivo de RTVE.

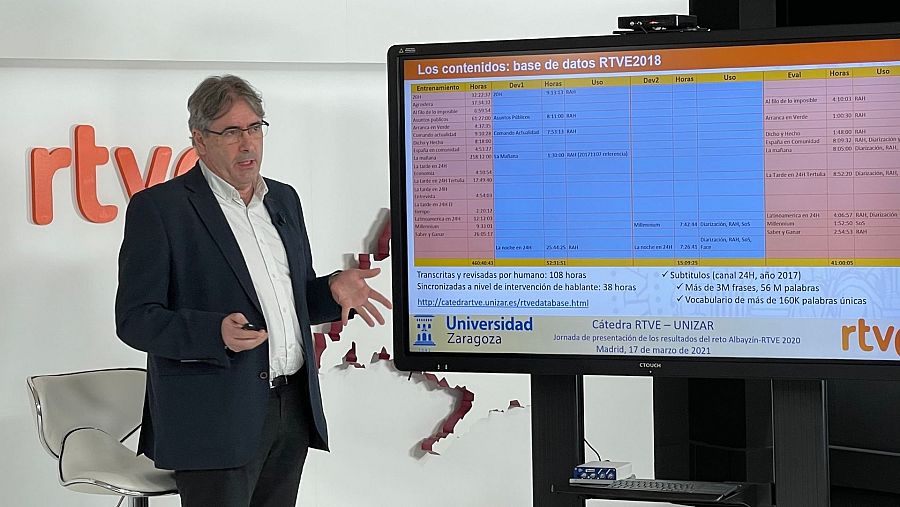

Eduardo Lleida, Director de la Cátedra RTVE – Universidad de Zaragoza, dio a conocer los resultados del reto Albayzín-RTVE 2020 destacando la participación de 11 grupos, a pesar de la compleja situación provocada por la pandemia, y señaló que el debate de los resultados tiene un espacio propio en el congreso Iberspeech 2020 en cuya web pueden consultarse las publicaciones de los grupos participantes. En este reto se han evaluado tres tecnologías; conversación de voz a texto, diarización y diarización multimodal. Respecto a la edición de 2018 se ha incrementado la cantidad de contenidos en la RTVE Database con la incorporación de programas de entretenimiento, y se ha añadido la asignación de identidad a la voz, lo que ha aumentado la dificultad del reto. El formato de video y audio con el que los participantes han trabajado es el formato estándar soportado por RTVE a la carta. Para ilustrar la complejidad de las tareas Eduardo Lleida mostró algunos clips de programas como “Cómo nos reímos”, “Los Desayunos de la 1” o “Vaya crack”, así como fragmentos de rodajes originales del programa “Imprescindibles”.

Eduardo Lleida, Director de la Cátedra RTVE - Universidad de Zaragoza RTVE

En el reto de reconocimiento automático del habla participaron 7 equipos y se evaluaron 17 sistemas distintos. Todos ellos, a excepción de 1, están basados en Kaldi, un sistema abierto que usa redes neuronales para hacer modelado acústico y de lenguaje. Para esta tarea los grupos participantes entrenaron sus sistemas con modelos acústicos de entre 600 y 4.000 horas y con modelos de lenguaje de entre 100.000 y 245.000 palabras, lo que nos da una idea de la cantidad de datos que se requieren para este tipo de tareas.

Si nos fijamos en la tasa de error de palabras mínima por programa, muestras como “Los desayunos” (7,9%), “Mercado Central” (12,8%), “Versión Española” (13,3%) y “Aquí la tierra” (13,9%) obtienen tasas de error por debajo del 20%. “Los desayunos” obtienen la tasa de error más baja, lo que pone de manifiesto el buen rendimiento de los sistemas con programas de corte informativo, en estudio y con condiciones acústicas óptimas. En el grupo de los contenidos que alcanzan una tasa de error más alta se encuentran las ficciones “Boca Norte” (33,3%), “Wake up” (31,8%), “Si fueras tú” (29%) y el programa de archivo “Cómo nos reímos”, formado por sketches de humor, con una tasa de error del 43,7%, la más alta obtenida.

Si nos centramos en el rendimiento de los sistemas evaluados y lo comparamos con los resultados obtenidos en 2018, apuntó Lleida, podemos afirmar que se ha producido una mejora considerable que, en algunos casos, como el del mejor sistema clasificado, ha supuesto una mejora de casi 4 puntos porcentuales. El grupo MLLP-VRAIN de la Universidad Politécnica Valencia con su sistema de streaming obtuvo una tasa de error media del 16,0% y por tanto resultó ganador en este reto, como ya sucediera en la edición de 2018.

La tarea de diarización de hablantes tenía como objetivo la segmentación del audio en hablantes y su agrupación posterior en función de cada hablante. De manera adicional los participantes podían asignar a cada fragmento una identidad. En esta tarea han participado 3 equipos y se han evaluado 5 sistemas diferentes. La principal dificultad ha sido la identificación de 161 voces a partir únicamente de una referencia de 20 segundos. En esta tarea se evalúan los sistemas de acuerdo con el error de diarización (DER), una métrica que, de forma muy resumida, tiene en cuenta los borrados, inserciones y sustituciones que un sistema automático produce al asignar un fragmento de voz a un hablante determinado.

Si analizamos la tasa de error de diarización por programas volvemos a encontrarnos con una gran disparidad de resultados según la dificultad. Así, por ejemplo, nos encontramos con programas con muy buen rendimiento como “Los desayunos” con un DER de 5,2% o “Aquí la Tierra” con un 14,5%. De nuevo, los programas de ficción obtiene los peores resultados con tasas de DER tan elevadas como un 61,6% en “Wake up”, un 64,7% en “Si fueras tú” o un 64,2% en “Boca Norte”. En la tarea de asignación de identidad los resultados empeoran significativamente, aunque se mantiene con mejores resultados el programa de “Los desayunos”, con un error de asignación de identidad del 35,6%. En los programas de ficción este error se encuentra por encima del 90%.

Si analizamos la tasa de error de diarización media para cada uno de los sistemas evaluados, observamos que el sistema ganador es el presentado por el grupo VivoLab de la Universidad de Zaragoza, con una tasa del 15,2%, mientras que los resultados para la tarea de asignación de identidad alcanzan el 65% para el mejor sistema presentado por Biometric Vox, de nuevo como consecuencia de la duración mínima de las referencias proporcionadas.

El objetivo de la tarea de diarización multimodal era segmentar contenidos media de acuerdo con un conjunto cerrado de personajes y agrupar los segmentos correspondientes a una misma voz y cara. Opcionalmente los grupos podían identificar y describir escenas sencillas como platós, exteriores, día, noche, invierno, verano, etc. En esta tarea han participado 3 grupos y se han evaluado 5 sistemas diferentes. En este caso los resultados siguen la misma línea que las otras dos tareas con un mejor rendimiento de los sistemas en programas de corte informativo o debates pausados, destacando el buen funcionamiento del sistema presentado por el grupo AtlantTic de la Universidad de Vigo, ganador del reto, por segunda vez, en esta ocasión con un 53,1% de DER en el global de todos los programas. Hay que destacar el mejor comportamiento en la identificación de personajes por su rostro con una menor variación entre programas informativos y de ficción. El mínimo error de asignación de identidad es para el programa “Aquí la Tierra” con un 25,6% y el máximo para “Comando actualidad” con un 65,1%, siendo la media global de programas de un 44,5%. Hay que destacar que en la identificación de personajes por el habla los resultados empeoran considerablemente, situándose el DER medio en el global de programas en el 61,6% pese al uso conjunto de información de rostros y voces. Si bien se puede observar una mejora notable del rendimiento de los sistemas, pese a haberse incrementado la dificultad del reto respecto a la edición de 2018, estos resultados, ponen de manifiesto que existe, aún, un gran margen de mejora.

Eduardo Lleida finalizó su intervención destacando la buena acogida de este reto entre la comunidad científica, así como el compromiso de la Catedra RTVE Universidad de Zaragoza con el impulso de las tecnologías en español. Los resultados demuestran el estado del arte de la tecnología y el objetivo para los próximos años es mantener y ampliar el conjunto de datos para dar soporte a otras tareas. La tecnología está disponible, pero son necesarios datos y los datos están en RTVE, remarcó el profesor Lleida.

Cerraron la jornada, que se pudo seguir en directo a través del Canal YouTube del Instituto RTVE, Pere Vila, Director de Estrategia Tecnológica e Innovación Digital de RTVE, y Alberto de Prada, Director del Fondo Documental RTVE. Pere Vila agradeció el trabajo realizado por la Cátedra RTVE Universidad de Zaragoza. Señaló, durante su intervención, que la Inteligencia Artificial se está haciendo un hueco cada vez mayor en los medios de comunicación y enfatizó que ésta constituye una gran oportunidad para complementar los recursos de los que ya dispone la Corporación RTVE. Finalmente, destacó como RTVE se nutre de esta estrecha colaboración con grupos de investigación a través de las 5 Cátedras que mantiene en la actualidad con distintas universidades españolas. Por último, Alberto de Prada señaló que este reto es el reflejo del trabajo que el Fondo Documental está realizando con la Cátedra y que tendrá como resultado la incorporación de esta tecnología a los procesos de trabajo del archivo, solo así será posible, afirmó, seguir avanzando en la preservación y acceso a los archivos de RTVE.

Pere Vila (RTVE) y Alberto de Prada (RTVE) RTVE

La Cátedra RTVE Universidad de Zaragoza ya trabaja en el que será el próximo reto Albayzín RTVE, para el que se ampliará el conjunto de datos, la dificultad de cada uno de los retos y para el que se espera contar con una mayor participación de grupos de investigación nacionales e internacionales.